英特尔Day0适配Qwen3-VL-4B/8B新模型,释放系统资源带来流畅体验

openlab_96bf3613

更新于 4月前

openlab_96bf3613

更新于 4月前

今晨,阿里通义又发布了Qwen3-VL的新成员,Qwen3-VL-4B和Qwen3-VL-8B。英特尔现已完成新模型在酷睿 Ultra 平台的适配。这是继十天前的Qwen3新模型Day0支持后的又一次快速适配,再一次印证了英特尔对持续推动AI技术创新、积极构建模型合作生态的坚实承诺。

此次发布的模型延续了Qwen3-VL模型系列的优秀的文本理解和生成能力、更深入的视觉感知和推理能力、更长的上下文长度、增强的空间和视频动态理解能力,以及强大的代理交互能力。同时,较小的模型参数量,使其在英特尔酷睿Ultra平台上的部署,可以获得优异的性能。酷睿Ultra的iGPU平台运行Qwen3-VL-4B的参考代码见文末。

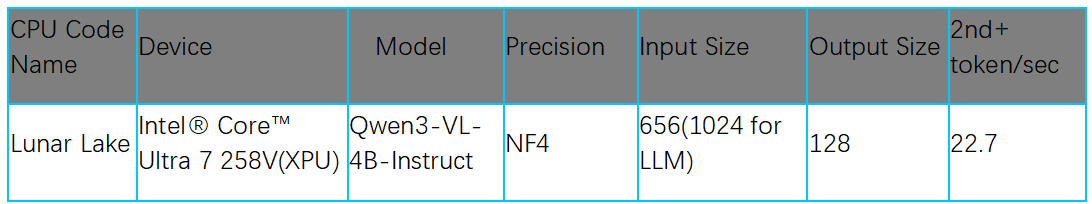

同时,英特尔通过对Qwen3-VL-4B 模型在酷睿Ultra的CPU、GPU和NPU平台进行混合部署,充分释放XPU架构的潜力,为用户带来前所未有的流畅AI体验。通过将复杂的视觉语言模型负载链路进行分解和优化,将更多负载精准调度至专用的NPU上,实现了:

- 显著的能效优化:大幅降低CPU占用率,更好支持用户并发应用

- 卓越的性能表现:在混合部署场景中,模型运行吞吐量达到22.7tps

- 流畅的用户体验:充分利用酷睿Ultra跨平台能力,提供无缝的AI交互

下面的演示视频直观地印证了这一成果:在运行图片理解与分析任务时,Qwen3-VL-4B模型充分展现了对NPU的高利用率与对CPU的低占用率。

视频:https://live.csdn.net/v/496375

再次快速回顾一下近期英特尔与阿里通义实验室取得的端侧AI模型和硬件的多项合作成果:

● 英特尔 Day 0优化Qwen3-VL MOE,多轮对话赋能AI PC更强理解力

Qwen3-VL系列模型带来了前所未有的视觉编程与Agent能力,现已在英特尔酷睿Ultra平台成功部署。优化后的Qwen3-VL-30B-A3B模型实现了28tps的高吞吐量,让开发者能在端侧流畅运行复杂视觉推理和多轮对话任务,轻松构建和实现更多创新应用场景。

视频:https://live.csdn.net/v/495397

● 英特尔AI PC部署Qwen3-Next-80B-A3B大模型, 解锁更多端侧智能体新应用

Qwen3-Next-80B-A3B模型凭借创新架构,以更低成本实现超越更大模型的性能,其关键的Gated DeltaNet算子获英特尔XPU平台原生支持。该模型现已成功部署于英特尔酷睿Ultra AI PC,在32K长上下文任务中实现23.43tps的吞吐量,效率达前代10倍,为端侧智能体解锁了处理复杂长文本任务和构建丰富智能体应用的能力。

视频:https://live.csdn.net/v/495396

● 英特尔客户端事业部和通义实验室联合发起“端侧AI创新挑战赛”,加速Qwen模型落地AI PC

英特尔客户端事业部与通义实验室联合发起“端侧AI创新挑战赛”,旨在激励开发者社区探索Qwen模型在AI PC上的创新应用,加速先进AI技术在端侧的落地实践。如需了解“端侧AI创新挑战赛”的详情情况,请参见:https://marketing.csdn.net/p/2259814a3f79579b5f7a00ffb3f48582?pId= 3133

快速上手指南

第一步,环境准备

基于以下命令可以完成模型部署任务在Python上的环境安装。

python -m venv py_venv./py_venv/Scripts/activate.batpip uninstall -y optimum transformers optimum-intelpip install torch==2.6.0 torchvision==0.21.0 torchaudio==2.6.0 --index-url https://download.pytorch.org/whl/cpupip install git+https://github.com/openvino-dev-samples/optimum.git@qwen3vlpip install git+https://github.com/openvino-dev-samples/transformers.git@qwen3vlpip install git+https://github.com/openvino-dev-samples/optimum-intel.git@qwen3vlpip install --pre -U openvino --extra-index-url https://storage.openvinotoolkit.org/simple/wheels/nightly

该示例在以下环境中已得到验证:

- 硬件环境:

o Intel® Core™ Ultra 7 258V

o iGPU Driver:32.0.101.6733

o Memory: 32GB

- 操作系统:

o Windows 11 24H2 (26100.4061)

- OpenVINO™版本:

o openvino 2025.3.0

第二步,模型下载和转换

在部署模型之前,首先需要将原始的PyTorch模型转换为OpenVINO™的IR静态图格式,并对其进行压缩,以实现更轻量化的部署和最佳的性能表现。通过Optimum提供的命令行工具optimum-cli,可以一键完成模型的格式转换和权重量化任务:

optimum-cli export openvino --model Qwen/Qwen3-VL-4B-Instruct --trust-remote-code --weight-format int4 --task image-text-to-text Qwen3-VL-4B-Instruct-ov

开发者可以根据模型的输出结果,调整其中的量化参数,包括:

-

--model: 为模型在HuggingFace上的model id,这里也提前下载原始模型,并将model id替换为原始模型的本地路径,针对国内开发者,推荐使用ModelScope魔搭社区作为原始模型的下载渠道,具体加载方式可以参考ModelScope官方指南:https://www.modelscope.cn/doc***odels/download

-

--weight-format:量化精度,可以选择fp32,fp16,int8,int4,int4_sym_g128,int4_asym_g128,int4_sym_g64,int4_asym_g64

-

--group-size:权重里共享量化参数的通道数量

-

--ratio:int4/int8权重比例,默认为1.0,0.6表示60%的权重以int4表,40%以int8表示

-

--sym:是否开启对称量化

第三步,模型部署

除了利用Optimum-cli工具导出OpenVINO™模型外,我们还在Optimum-intel中重构了Qwen3-VL和Qwen3-VL-MOE模型的Pipeline,将官方示例示例中的的Qwen3VLForConditionalGeneration替换为OVModelForVisualCausalLM便可快速利用OpenVINO™进行模型部署,完整示例可参考以下代码流程。

from transformers import AutoProcessorfrom optimum.intel import OVModelForVisualCausalLM# default: Load the model on the available device(s)model = OVModelForVisualCausalLM.from_pretrained("Qwen3-VL-4B-Instruct-ov", device="GPU")processor = AutoProcessor.from_pretrained("Qwen3-VL-4B-Instruct-ov")messages = [{"role": "user","content": [{"type": "image","image": "https://qianwen-res.oss-cn-beijing.aliyuncs.com/Qwen-VL/assets/demo.jpeg",},{"type": "text", "text": "Describe this image."},],}]# Preparation for inferenceinputs = processor.apply_chat_template(messages,tokenize=True,add_generation_prompt=True,return_dict=True,return_tensors="pt")# Inference: Generation of the outputgenerated_id*****odel.generate(**input****ax_new_tokens=128)generated_ids_trimmed = [out_ids[len(in_ids) :] for in_ids, out_ids in zip(inputs.input_ids, generated_ids)]output_text = processor.batch_decode(generated_ids_trimmed, skip_special_tokens=True,clean_up_tokenization_spaces=False)print(output_text)

以下为该模型在图像理解任务中的输出示例:

'This is a heartwarming, sun-drenched photograph capturing a tender moment between a woman and her dog on a beach at sunset.\n\n**Key Elements:**\n\n* **The Subjects:** A young woman with long dark hair, wearing a plaid shirt, sits on the sand. Beside her, a large, light-colored dog, likely a Labrador Retriever, sits attentively, wearing a harness. The two are engaged in a playful, paw-to-paw high-five or "pawshake" gesture, a clear sign of their bond.\n* **The Setting:** They are on a wide, sandy beach.

*The performance data was obtained through testing conducted using the OpenVINO framework version 2025.4.0.dev20250922 on Ultra7 258V , computing happened on XPU. The tests evaluated first-token latency, and average throughput for 1K input under nf4-mixed-cw-sym precision settings. Each test was executed three times following a warm-up phase, with the avg value selected as the reported data.