【保姆级】OpenClaw+Ubuntu 安装指南:本地高权限AI智能体 + 钉钉接入 + HAI 模型中转

先认识一下 OpenClaw

OpenClaw 经过三次改名(Clawdbot → Moltbot → OpenClaw),小编更习惯叫它 小龙虾助手:一个运行在本地/服务器上的高权限 AI 智能体,适合做自动化与长期任务。

它能做什么?

· 本地部署:跑在你的服务器或电脑上,数据更可控

· 多平台接入:可对接飞书、钉钉、WhatsApp、Telegram、Discord、Slack 等聊天工具(具体以插件支持为准)

· 浏览器控制:浏览网页、填写表单、抓取信息

· 系统访问:读写文件、执行 Shell 命令、运行脚本

· 持久化记忆:记住偏好与上下文,越用越顺手

· 插件扩展:支持社区插件,也可以自己写插件

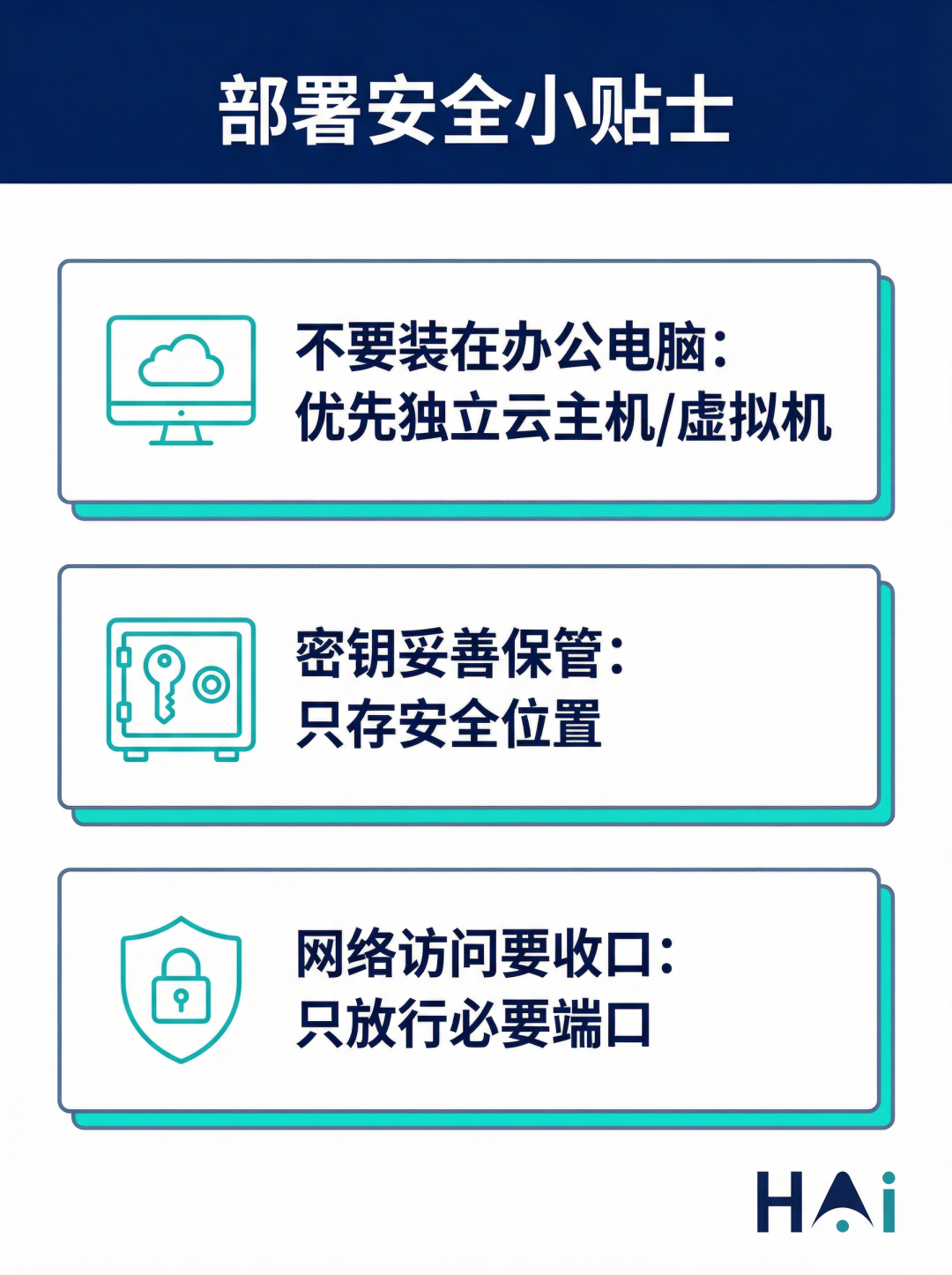

写在前面:安全建议一定要看

小龙虾助手的能力很强,但也意味着权限很大。小编建议你按下面的方式做“最小风险”部署:

· 尽量不要装在日常办公电脑:建议使用独立云主机/虚拟机/闲置机器

· 密钥不写进文档:避免在公开内容中出现任何真实密钥

· 网络访问要收口:只放行必要端口与目的地址,避免暴露在公网

准备清单(Ubuntu 示例)

· 一台 Ubuntu 服务器/虚拟机(建议 22.04+)

· 能正常联网(用于安装依赖、拉取脚本/插件)

· 可访问 HAI 平台的 API 中转服务(用于模型调用)

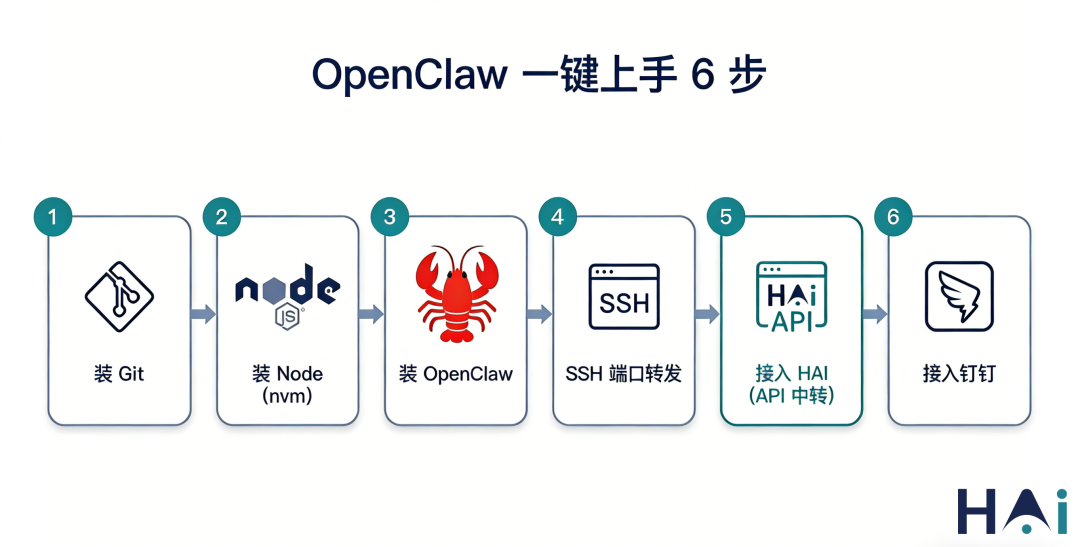

安装步骤(一步一步来)

1)安装 Git

sudo apt update

sudo apt install git -y

2)安装 Node.js(推荐用 nvm)

安装 nvm

curl -o- https://raw.githubusercontent.com/nvm-sh/nvm/v0.39.7/install.sh | bash

让 nvm 生效

source ~/.bashrc

按终端提示选择其一即可,通常使用上面这条命令。

安装并使用 Node.js(以 Node 20 为例)

nvm install 20

nvm use 20

nvm alias default 20

验证安****>

node -v

npm -v

3)安装 OpenClaw

# 使用官方脚本安***r/>curl -fsSL https://openclaw.bot/install.sh | bash

这一步网上资料很多,小编这里就不展开“为什么这样装”,重点放在后面的远程访问与模型接入。

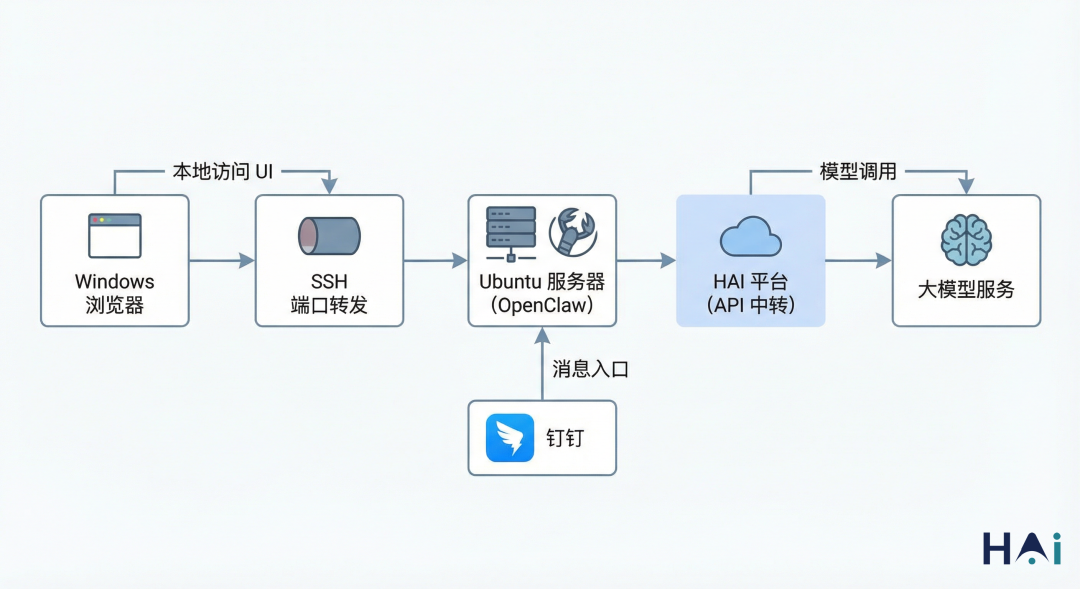

远程访问 UI(Windows 端口转发)

很多人把 OpenClaw 装在远端 Ubuntu 上,但出于安全考虑它常会绑定在 127.0.0.1。如果你想在本地 Windows 浏览器打开 UI,可以用 SSH 端口转发。

在 Windows 的 CMD 或 PowerShell 中执行:

ssh -L 18789:127.0.0.1:18789 <user>@<remote_host>

参数说明:

· <user>:你的 Ubuntu 账户名

· <remote_host>:你的 Ubuntu IP 或域名

· -L 本地端口:远端地址:远端端口

· 127.0.0.1:18789 指的是远端 Ubuntu 自己的 localhost:18789

然后在 Windows 浏览器打开:

http://localhost:18789/

注意事项:

· 这个 SSH 窗口需要保持连接不断开(转发通道在这条连接上)

· 想免密登录可自行配置 SSH免密登录

架构示意图:

重点:通过 HAI 平台接入“API 中转/多模型”

如果你希望更省心地管理多模型、统一计费或做 API 中转,小编建议直接用 HAI 平台来承接模型调用(购买资源后按需配置)。

1)在 HAI 获取 API Key 与中转地址

在 HAI 控制台创建你的 API Key,并确认你要使用的中转能力对应的 Base URL(不同产品形态路径可能不同)。

提醒:API Key 属于敏感信息,务必妥善保管,避免写进截图/文档/代码仓库。

2)配置 OpenClaw 的模型 Provider

下面是一个已用占位符处理的示例。你只需要把 <HAI_RELAY_BASE_URL>、<HAI_API_KEY> 和模型列表替换成你在 HAI 里实际开通的内容即可。

openclaw config set 'models.providers.hai' --json '{

"baseUrl": "https://<HAI_RELAY_BASE_URL>/open-api/v1/relay/anthropic",

"apiKey": "<HAI_API_KEY>",

"api": "anthropic-message*****r/> "models": [

{ "id": "claude-opus-4-5", "name": "claude-opus-4-5" },

{ "id": "claude-sonnet-4-20250514", "name": "claude-sonnet-4-20250514" }

]

}'

3)设置默认模型

openclaw models set hai/claude-sonnet-4-20250514

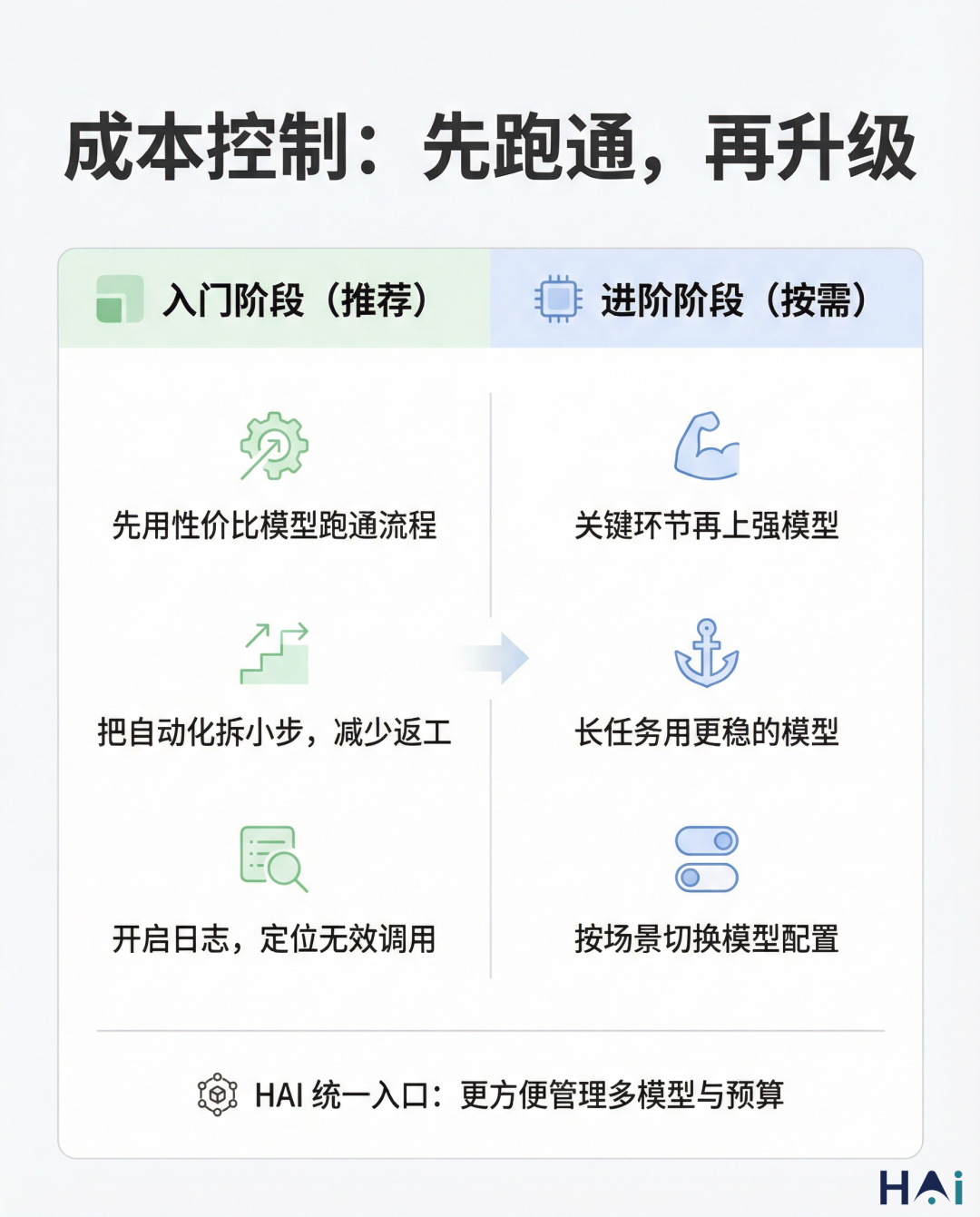

4)用量小贴士(帮你省钱)

· OpenClaw 在“自动化/多步任务”里 token 消耗可能更明显

· 建议先用性价比更高的模型跑通流程,再按需切换更强的模型

接入钉钉(插件方式)

想把小龙虾助手“搬到聊天窗口”,钉钉是很常见的入口。下面给一个可复用的插件接入流程。

1)安装钉钉插件

openclaw plugins install https://github.com/soimy/clawdbot-channel-dingtalk.git

2)准备钉钉侧的应用/机器人信息

你需要在钉钉开放平台创建应用/机器人,拿到下面这些参数:

· clientId

· clientSecret

· robotCode

· corpId

· agentId

3)配置机器人(占位符示例)

openclaw config set 'channels.dingtalk' '{

"enabled": true,

"clientId": "<DINGTALK_CLIENT_ID>",

"clientSecret": "<DINGTALK_CLIENT_SECRET>",

"robotCode": "<DINGTALK_ROBOT_CODE>",

"corpId": "<DINGTALK_CORP_ID>",

"agentId": "<DINGTALK_AGENT_ID>",

"dmPolicy": "open",

"groupPolicy": "open",

"messageType": "markdown",

"debug": false

}'

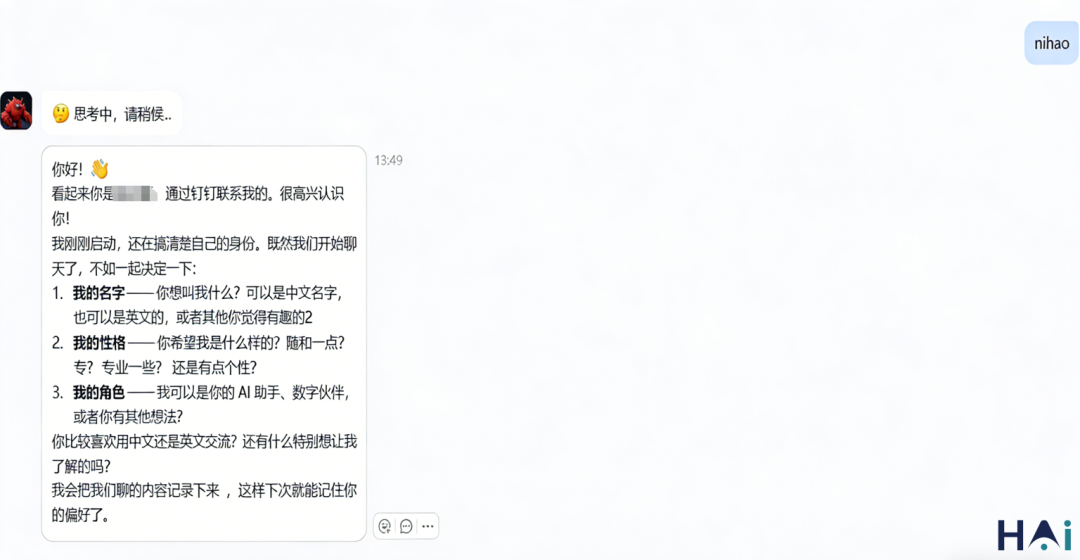

最终效果

1. 学习/资料整理

有灵感时,直接在钉钉丢一段语音/文字,让它自动整理成笔记、清单或文章草稿。

2. 日常自动化

比如:拉取网页信息、生成日报周报、汇总会议纪要、把数据写进指定文件夹等。

如果你也想把模型调用统一到一个“可购买、可扩展、可管理”的入口,小编更推荐在 HAI 平台上开通 API 中转资源,再把 OpenClaw 的模型 Provider 指向 HAI,这样后续扩模型、控成本会更顺。

总结

到这里,你已经可以在 Ubuntu 上完成 OpenClaw(小龙虾助手)的部署,并通过 Windows 端口转发访问 UI,再把模型调用接入到 HAI 平台,最后用钉钉把它“放进聊天窗口”。

如果你希望小编再补一篇「HAI 上如何选模型/如何开通中转/如何做成本监控」的实操版,也可以继续留言,小编就按你们最关心的点把坑填齐。