【爱克斯开发板试用】Intel Open Model Zoo英特尔训练模型库验证与Open5GS网元部署

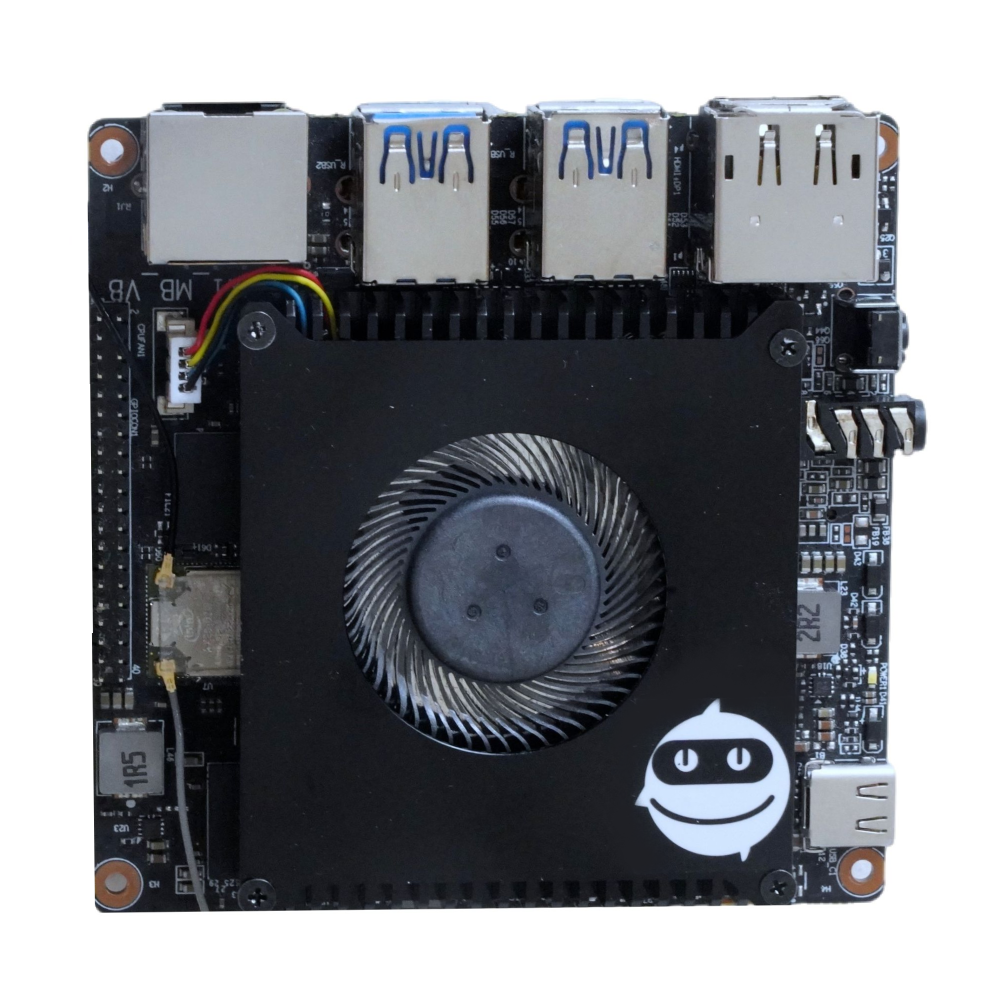

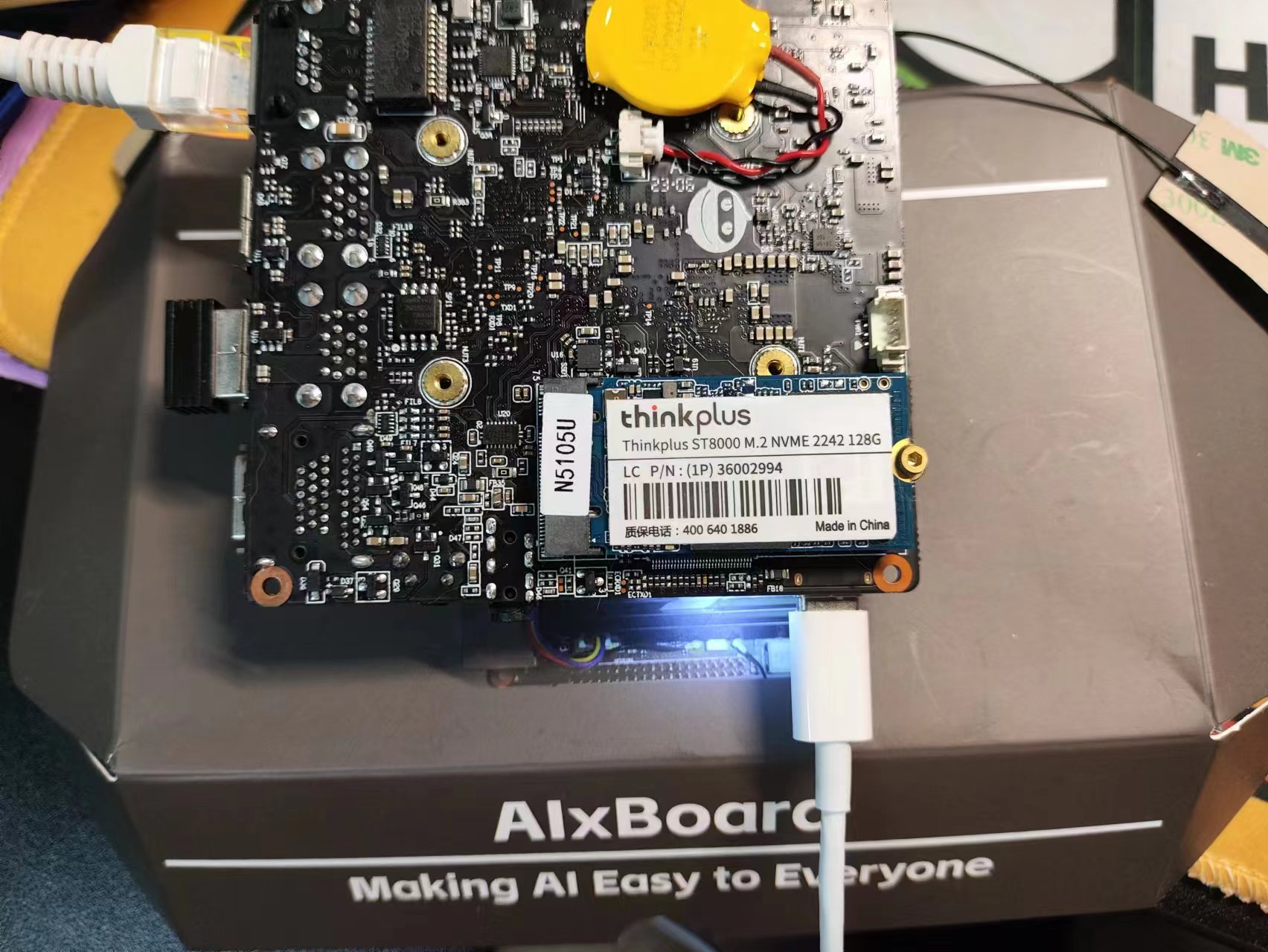

作者:徐万腾 周峰 费颖超 公司:东方通信股份有限公司 一、前言 本次使用的开发板型号为AIxBoard-N5105,开发公司为蓝蛙智能。蓝蛙智能作为英特尔OpenVINO官方技术伙伴,在2023年推出英特尔数字化开发套件爱克斯板AIxBoard-N5105。作为入门级人工智能应用和边缘智能设备,爱克斯板能完美胜人工智能学习、开发、实训、应用等不同应用场景。二、产品开箱展示三、Int

witt.xu

2年前

witt.xu

2年前

【2023 Intel有奖征文】行人摔倒检测 — 基于 OpenVINO C# API 部署PP-Human

随着人口老龄化问题的加重,独居老人、空巢老人数量在不断上升,因此如何保障独居老人、空巢老人健康生活和人身安全至关重要。而对于独居老人、空巢老人,如果出现摔倒等情况而不会及时发现,将会对其健康安全造成重大影响。本项目主要研究为开发一套摔倒自动识别报警平台,使用视频监控其采集多路视频流数据,使用行人检测算法、关键点检测算法以及摔倒检测算法实现对行人摔倒自动识别,并根据检测情况,对相关人员发送

椒颜皮皮虾

2年前

椒颜皮皮虾

2年前

【2023 Intel有奖征文】基于爱克斯板开发属于自己的AI作画助手

爱克斯板:英特尔数字化开发套件AIxBoard(X板)是一款IA架构的人工智能嵌入式开发板,体积小巧功能强大,可让您在图像分类、目标检测、分割和语音处理等应用中并行运行多个神经网络。它是一款面向专业创客、开发者的功能强大的小型计算机,借助OpenVINO工具套件,CPU、iGPU都具备强劲的AI推理能力,为您下一款基于 AI 的产品进行原型设计并将其快速推向市场的理想解决方案。 OpenVINO:

Tango

2年前

Tango

2年前

【爱克斯开发板试用】爱克斯开发板使用OpenVINO C# API

英特尔发行版 OpenVINO™工具套件基于oneAPI 而开发,可以加快高性能计算机视觉和深度学习视觉应用开发速度工具套件,适用于从边缘到云的各种英特尔平台上,帮助用户更快地将更准确的真实世界结果部署到生产系统中。通过简化的开发工作流程, OpenVINO™可赋能开发者在现实世界中部署高性能应用程序和算法。 C#是由C和C++衍生出来的一种安全的、稳定的、简单的、优雅的面向对象

椒颜皮皮虾

2年前

椒颜皮皮虾

2年前

开发目的:RFID技术在物联网应用中扮演着重要的角色,通过将RFID设备与Edgex平台集成,可以实现工厂车间内的资产管理、物流运输中的货物流转等功能,其特点是可以高效、可靠的管理设备和采集数据。 一、RFID技术介绍: 射频识别(RFID)技术是一种无线通信技术,可以实现对物体的自动识别和跟踪。它由RFID标签、读写器和管理系统组成,广泛应用于物流、仓储、供应链管理等领域。 二、Edgex平台简

openlab_ed3aac16

2年前

openlab_ed3aac16

2年前